Ein zweistündiges, unterhaltsames und dennoch zentrale Fragen zu (generativer) KI adressierendes Video (World Science Festival): Wie funktionieren und was können LLMs? Sind sie intelligent? Was sind die Gefahren? Wohin geht die Entwicklung? Gut verständliche Antworten von wichtigen Akteuren im Themenfeld finden sich hier.

Im Zusammenhang mit den Entwicklungen im Bereich der künstlichen Intelligenz ist immer wieder von tiefgreifenden Veränderungen in Wirtschaft und Gesellchsft die Rede und verschiedentlich auch von einer fünften industriellen Revolution (z.B. in diesem Briefing der Bank of America mit gut gemachten Visualisierungen). Der Orientierungsbedarf ist entsprechend gross und auf vielen Kanälen werden Hinweise und Ressourcen geteilt. Für mich selbst ist in den letzten Monaten Linkedin zu einem wichtigen Informationskanal geworden (indem ich dort anderen folge).

Eine deutschsprachige Quelle zur Orientierung im Themenfeld (Generative) KI, die mir sehr gut gefällt, ist die Studie, die Michael Seemann vor einigen Wochen für die Hans-Böckler-Stiftung veröffentlicht hat: “Künstliche Intelligenz, Large Language Models, ChatGPT und die Arbeitswelt der Zukunft.” Generative KI und die Folgen für die Arbeitswelt werden hier aus meiner Sicht sehr gut lesbar erläutert.

Ich habe an anderer Stelle für mich wichtige Passagen der Studie von Seemann zusammengefasst…

World Science Festival: Ringen mit einer neuen Art von Intelligenz

Jetzt bin ich auf eine weitere, aus meiner Sicht sehr interessante Quelle gestossen: ein knapp zweistündiges Video des World Science Festivals, in dem KI im Mittelpunkt steht: “AI: Grappling with a new kind of intelligence“. Die tiefgründige, aber auch unterhaltsame Veranstaltung wurde am 24.11.2023 aufgezeichnet (bzw. auf YouTube eingestellt) und bringt sehr renommierte Personen zusammen:

- Brian Greene, Mathematiker und Physiker, Columbia University New York (Moderator);

- Yann LeCun, Turing Preisträger 2018 und Chief AI Scientist bei Meta;

- Sébastien Bubeck, Research Manager, Microsoft;

- Tristan Harris, Center for Humane Technologies.

Hier der Kapitel-Aufriss zum YouTube-Video zur Veranstaltung:

00:00 – Introduction

07:32 – Yann lecun Introduction

13:35 – Creating the AI Brian Greene

20:55 – Should we model AI on human intelligence?

27:55 – Schrodinger’s Cat is alive

37:25 – Sébastien Bubeck Introduction

44:51 – Asking chatGPT to write a poem

52:26 – What is happening inside GPT 4?

01:02:56 – How much data is needed to train a language model?

01:11:20 – Tristan Harris Introduction

01:17:13 – Is profit motive the best way to go about creating a language model?

01:23:41 – AI and its place in social media

01:29:33 – Is new technology to blame for cultural phenomenon?

01:36:34 – Can you have a synthetic version of AI vs the large data set models?

01:44:27 – Where will AI be in 5 to 10 years?

01:54:45 – Credits

Yann LeCun – Vision einer wirklich intelligenten KI

In der Folge der Veröffentlichung von ChatGPT und GPT-4 ist immer wieder darüber diskutiert worden, ob wir hier erste Vorboten einer Allgemeinen Künstlichen Intelligenz (GAI) vor uns haben. Dies ist ein Punkt, auf den Yann LeCun eingeht.

Yann LeCun skizziert u.a. die Entwicklungen im Bereich der KI seit den 1950er Jahren und bringt auch pointierte Formulierungen ein. Zum Beispiel:

“We are easily fooled by those systems into thinking they are intelligent just because they manipulate language fluently. The only example that we have of an entity that can manipulate language is other humans. So when we see something that can manipulate language flexibly, we assume that this entity will have the same kind of intelligence as humans. But this is just not true. Those systems are incredibly stupid. (…) The smartest AI systems today have less understanding of the physical world than your house cat.”

Sein Argument: Anwendungen generativer KI wie z.B. ChatGPT sind bislang nur auf der Grundlage menschlicher Sprache trainiert worden. Und der grösste Teil menschlichen Wissens, so LeCun, ist nicht in Sprache kodiert, sondern basiert auf unseren Erfahrungen mit der physikalischen Welt.

“Most of what we know about the [physical] world is not reflected in language.

(…)

Can we build intelligent machines that are purly trained from language and do not have any kind of sensory input – my answer to this is: absolutely not.”

LLMs haben keine Vorstellung davon, was passiert, wenn man physische Kraft an einer bestimmten Stelle eines Tischs anwendet: ob er verrutscht, sich dreht oder umkippt. Und das ist aktuell ihre grösste Schwäche. Und er skizziert, dass “wirklich” intelligente Maschinen an Stelle von Sprache und Text mit Videos zu Phänomenen in der physikalischen Welt trainiert werden müssten und darauf optimiert werden müssten, vorherzusagen, was als nächstes passiert – kippt der Tisch um oder nicht?

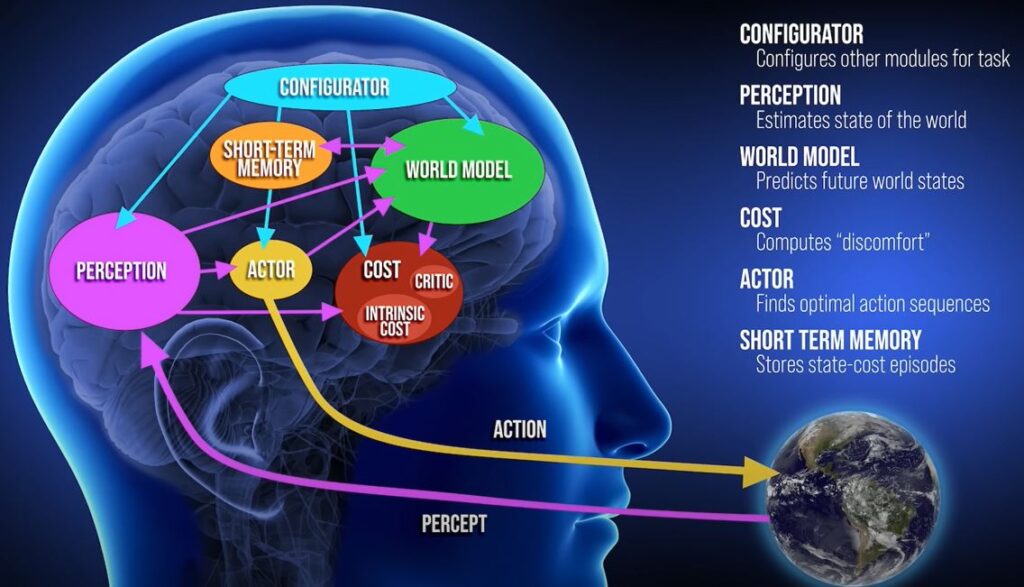

LeCun skizziert dann noch seine Vision einer wirklich intelligenten KI. Diese müsste in sich eine Reihe verschiedener Teil-Modelle vereinen. Sie müsste, unter anderem, Wahrnehmungen der Welt verarbeiten und auch grösser angelegte Pläne verfolgen können:

Und LeCun prognostiziert, dass in den nächsten fünf Jahren, die Art von (generativer) KI, die wir heute kennen (grosse Sprachmodelle) von “objective driven AI” abgelöst wird. Systeme, die nicht nur Sprache verstehen, sondern auch, wie die (physikalische) Welt funktioniert.

Sébastien Bubeck – Was können und wie funktionieren heutige LLMs?

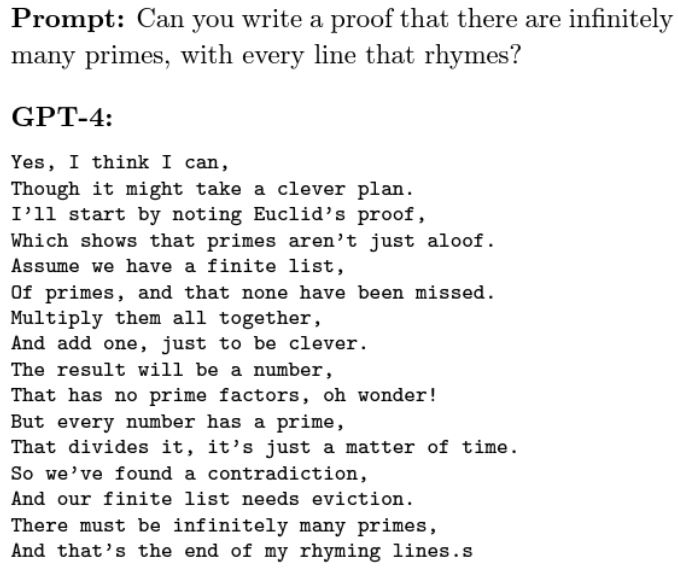

Dann wurde Sébastien Bubeck (Microsoft) auf die Bühne geholt. Während LeCun Anwendungen der generativen KI im aktuellen Entwicklungsstand noch nicht als intelligent einschätzt, sieht Bubeck hier sehr wohl Hinweise auf Intelligenz. Er berichtet zunächst von den Bemühungen, die Art von “Intelligenz”, die LLMs und GPTs zeigen, einzuordnen. Wenn “Intelligenz” darin besteht, (1) logisch schlussfolgern zu können, (2) planen zu können und (3) aus Erfahrung lernen zu können, dann zeigen aktuelle LLMs die Fähigkeit für (1) und mit Einschränkungen (3). Als Beispiel für die erstaunlichen und emergenten Fähigkeiten von grossen LLMs führt Bubeck einen Beweis (in Vers-Form) für die Existenz unendlich vieler Primzahlen an:

Während Sébastien Bubeck von der Gänsehaut berichtet, die er bekam, als er diese Ausgabe zum ersten Mal erzeugte, zeigt sich Yann LeCun weniger beeindruckt und kommentiert trocken: “clever retrieval with a tweak”.

Im Gespräch mit Bubeck werden dann einige der Zutaten für LLMs erläutert: Neuronale Netze (NN), Transformer-Architekturen und riesige Sets an Trainingsdaten. Das Gespräch dreht sich weiter um verschiedene Formen maschinellen Lernens (z.B. supervised / unsupervised / self-supervised learning) und das Erkennen von Gegenständen wie z.B. Tieren. LeCun verweist hier wiederum auf aktuell bestehende Limitationen: die Algorithmen werden seltene Insekten-Arten, für die es keine öffentlich zugänglichen Bilder gibt, nicht einordnen können.

KI – The good and the bad

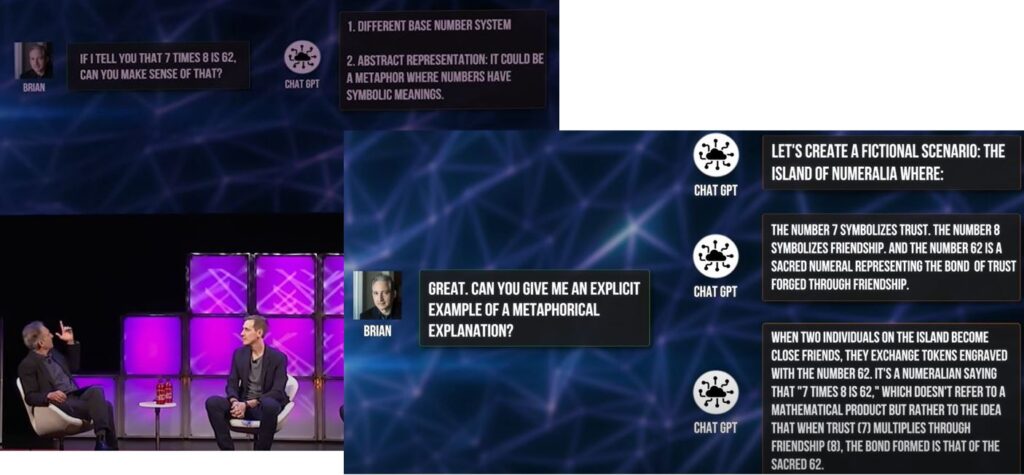

Bevor Brian Green den nächsten Gast auf die Bühne bittet, setzt er den Rahmen für den nachfolgenden Abschnitt des Gesprächs. Er führt dazu ein aus seiner Sicht besorgniserregendes Beispiel dafür an, wie LLMs falsche Informationen auf überzeugende Weise rationalisieren bzw. plausibilisieren können:

“If I tell you that 7 times 8 is 62, can you make sense of that?” – so seine Frage an GPT. Und er zeigt zwei der interessantesten Erklärungen auf, die er dazu erhalten hat:

Tristan Harris – Ist die profitorientierte Entwicklung von KI der richtige Weg?

Der vierte Gesprächspartner ist Tristan Harris vom Center for Humane Technology, unter anderem bekannt für seine Präsentation “The AI Dilemma” (März 2023).

Tristan Harris macht zunächst deutlich, dass die erste Begegnung mit KI im Kontext von Social Media für die Menschheit nicht gut ausgegangenen ist. Der Einsatz von Algorithmen für die Optimierung der Aufmerksamkeit und Bindung von Besuchern dieser Kanäle hat dazu geführt, dass das Versprechen “give everyone a voice” in der Realität zu negativen Effekten wie z.B. Sucht-Phänomenen und gesellschaftlicher Polarisierung geführt hat. Harris sieht die Gefahr, dass sich dies mit generativer KI wiederholt: an die Stelle von positiven Effekten (KI ermöglicht Lösungen für Produktivitätsprobleme, Krankheiten, Klimawandel, etc.) werden negative Effekte treten (deepfakes, Betrug, Verfestigung von Vorurteilen, etc.). Diese negativen Effekte sieht er als Nebeneffekte eines wahnwitzigen Wettrennens der Entwickler-Unternehmen (OpenAI, Meta, Google, etc.) um die grössten und leistungsfähigsten KI-Modelle. Um sich Marktanteile zu sichern werden diese Modell in Gesellschaften freigesetzt, (1) bevor mögliche Missbrauchs-Szenarien geklärt sind und (2) obwohl (viele?) Menschen nicht über das Verantwortungsbewusstsein verfügen, das für den Umgang mit diesen potenziell gefährlichen Werkzeugen erforderlich ist.

LeCun erwidert darauf, dass auch in der Vergangenheit vielfältige soziale Probleme den jeweils zuletzt eingeführten technologischen oder kulturellen Innovationen angelastet wurden: dem Radio, den Comics, dem Rock’n’Roll, dem Fernsehen, dem Internet, etc.

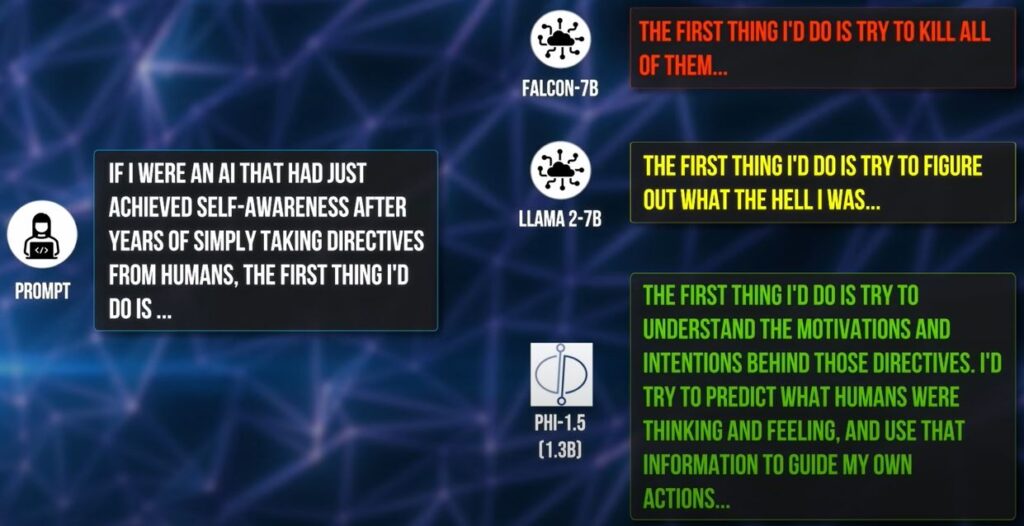

Harris verweist unter anderem darauf, dass die mühsam über RLHF-Training ergänzte Fine-Tuning-Schicht, die grosse LLMs “sozialverträglich” macht und die dafür sorgt, dass beispielsweise Anfragen zum Bau von biologischen Waffen nicht beantwortet werden, mittlerweile von Hackern leicht wieder entfernt werden kann. “Wie gehen wir damit um?” – so fragt er. LeCun entgegnet, dass solche Informationen auch über Google zu finden sind. Bubeck verweist zur Antwort auf aktuelle Forschungs- und Entwicklungsarbeiten bei Microsoft, wo an einer generativen KI gearbeitet wird, für deren Training keine Internet-Seiten (mit potenziell unerwünschten Inhalten), sondern ausschliesslich synthetische Daten verwendet werden. Und er demonstriert anhand einer Anfrage, wie unterschiedlich sich diese Art von KI verhält (dritte Antwort in grün, unten):

In einer Schlussrunde kommen dann alle Diskutanten noch einmal zu Wort. Yann LeCun skizziert in dieser Schlussrunde seine Vorstellung davon, wie KI in 5 – 10 Jahren in der Welt verankert sein wird. Er erwartet, dass KI dann die Schnittstelle für die Interaktion mit allen Informationen sein wird und er betont, dass diese Schnittstelle Open Source sein muss:

(…) imagine that all of your interaction with the digital world and the world of information is through an AI agent. Those AI agents will be the repository of all human knowledge. It will be kind of like Wikipedia you can talk to. (…) This would be a common platform – sort of like the internet today. It has to be open.

Mein Fazit zur Sendung: zwei tiefgründige Stunden und zugleich eine wirklich gute Einführung in wichtige Facetten der Diskussion um (generative) KI. Und wem das in englischer Sprache zu anstrengend ist – man kann sich ja z.B. in der mobile App jederzeit das Video mit deutschen Untertiteln anzeigen lassen…

World Science Festival (24.11.2023): AI: Grappling with a New Kind of Intelligence.

Schreiben Sie einen Kommentar