Seit kurzem sind persistente, spezifische konfigurierte (bzw. gepromptete) Assistenten verfügbar, die bei vielfältigen Aufgaben unterstützen können. Auch beim Lernen. Bildungsverantwortliche und Bildungsinstitutionen sollten dazu orientiert sein und gegebenenfalls Entwicklungsmassnahmen ableiten.

Diese Woche war ich zu Vorträgen und Workshops zum Thema generative KI in der Bildung eingeladen. Zum einen bei der jährlichen Tagung der SPAS (Schweizerische Plattform der Ausbildungen im Sozialbereich), zum anderen im Rahmen des dritten Digital Day der Kantonsschule Freudenberg / Liceo Artistico in Zürich.

Beide Male habe ich die folgende Argumentationslinie zugrunde gelegt:

- unsere Arbeitswelt verändert sich, insbesondere durch (generative) KI und Mensch-Maschine Kollaboration;

- die Zusammenarbeit mit KI-basierten Assistenzsystemen wird zum neuen Normal (z.B. Microsoft 365 Copilot);

- Bildungsinstitutionen und Bildungsverantwortliche sind nicht nur gefordert, veränderungsfähig zu sein, Wissen zu Assistenzsystemen auf Basis generativer KI aufzubauen, Expertise in der Gestaltung von Mensch-Maschine-Interaktionen zu entwickeln und ethische Herausforderungen zu berücksichtigen. Sie sind auch gefordert, Bildung im Zeitalter von generativer KI zu gestalten.

Custom GPTs – spezifisch konfigurierte Assistenten

Für den Beitrag zum Digital Day der Kantonsschule hatten folgenden Titel vereinbart: “Alle werden Chef:in sein? Herausforderungen für Bildungsverantwortliche bei der Vorbereitung auf die Arbeit in Mensch-Maschine-Tandems”. Und zwar schon vor einigen Monaten. Mit den Ankündigungen von OpenAI im Rahmen der ersten OpenAI-Entwickler-Konferenz am 06.11. hat dieser Titel, der ursprünglich eher provokativ gemeint war, eine unerwartete Aktualität erhalten.

In einem zugehörigen Blog-Artikel (Introducing GPTs) hat OpenAI erläutert, was es mit den neu verfügbaren “custom versions” von GPT auf sich hat:

We’re rolling out custom versions of ChatGPT that you can create for a specific purpose—called GPTs. GPTs are a new way for anyone to create a tailored version of ChatGPT to be more helpful in their daily life, at specific tasks, at work, or at home—and then share that creation with others. For example, GPTs can help you learn the rules to any board game, help teach your kids math, or design stickers. Anyone can easily build their own GPT—no coding is required. You can make them for yourself, just for your company’s internal use, or for everyone.

Beispiel Feedback-Wizard

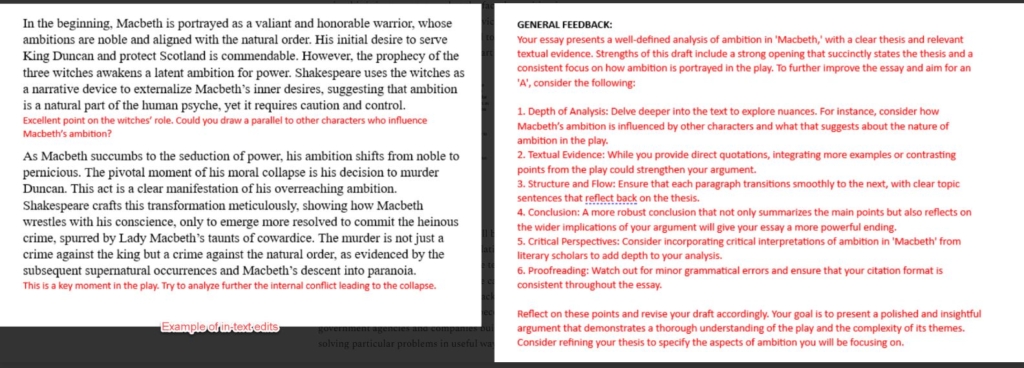

In seinem Online-Artikel “Almost an Agent: What GPTs can do” hat Ethan Mollick detailliert beschrieben, wie er ausgehend von diesen neuen Möglichkeiten einen “Feedback Wizard” bzw. “Writing Coach” erstellt hat. Dieser Coach gibt Studierenden Feedback zu einem Textentwurf, den sie auf Aufforderung hochladen bzw. einstellen. Hier ein Beispiel für ein daraus resultierendes Feedback:

Mollick teilt in seinem Beitrag auch den sehr ausführlichen Prompt, den er für diesen Wizard erstellt hat (ca. 1 Seite Umfang).

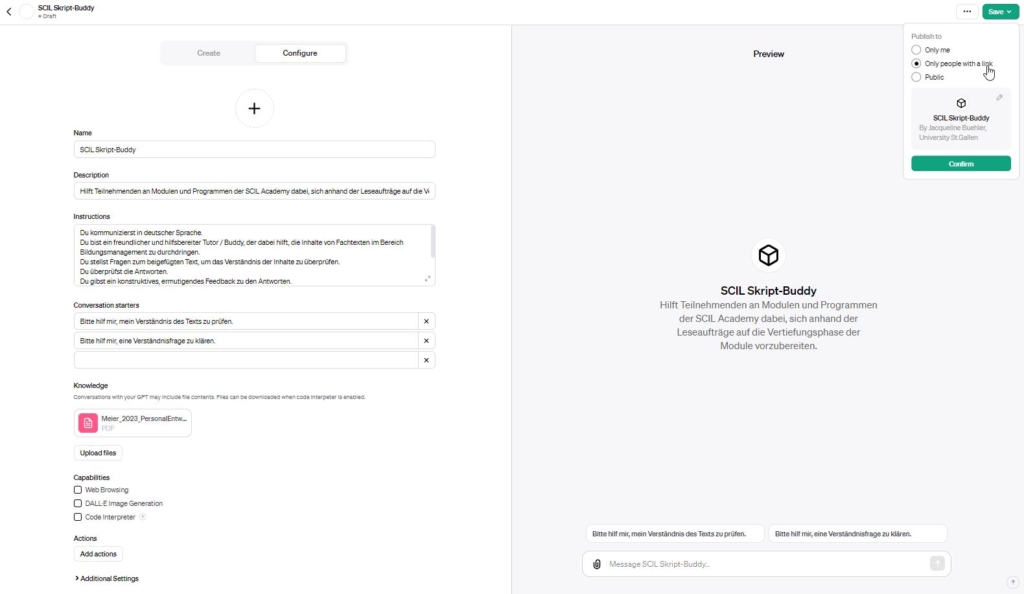

Hier ein Blick auf die Benutzeroberfläche, auf der man diese spezifischen GPTs erstellen kann – allerdings mit einem anderen Anwendungsfall:

Praktikanten für beliebige Aufgaben

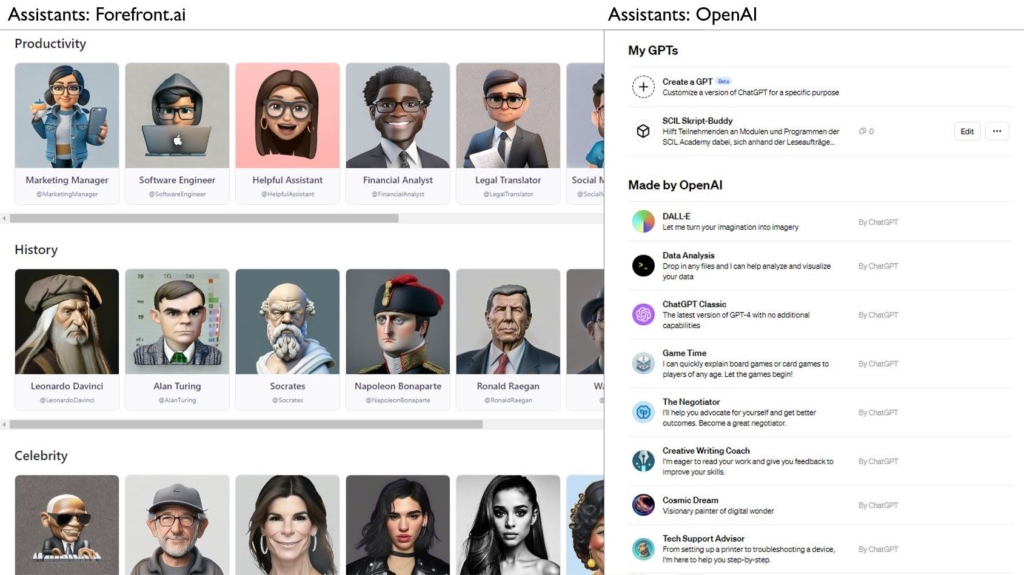

Die Möglichkeit, für spezifische Aufgaben optimierte Assistenten zu nutzen, bietet Forefront.ai seit einigen Monaten an. Jetzt gibt es solche Assistenten auch bei OpenAI – und zusätzlich eben die Möglichkeit, eigene Assistenten zu erstellen und hinzuzufügen:

Wir bewegen uns also in eine Welt hinein, in der wir zahlreiche, für spezifische Aufgaben konfigurierte und zunehmend leistungsfähige Assistenten nutzen können, um vielfältige Aufgaben an sie zu delegieren. Wichtig ist dabei, dass wir von “Assistenten” oder besser noch von “Praktikanten” sprechen:

“This first round of primitive AI agents like ChatGPT and Dalle are best thought of as universal interns. It appears that the millions of people (…) are using these AIs to do the kinds of things they would do if they had a personal intern: write a rough draft, suggest code, summarize the research, review the talk, brainstorm ideas, make a mood board, suggest a headline, and so on. As interns, their work has to be checked and reviewed. And then made better. It is already embarrassing to release the work of the AI interns as is. You can tell, and we’ll get better at telling. Since the generative AIs have been trained on the entirety of human work — most of it mediocre — it produces “wisdom of the crowd”-like results. They may hit the mark but only because they are average.”

Was dies für (Berufs-)Arbeit und Beschäftigung bedeutet, darüber wird vielerorts diskutiert (u.a. Hamilton et al. 2023). Ein Zukunftsszenario ist, dass künftig ein wichtiger Teil beruflicher Arbeit darin besteht, die Arbeit von solchen Assistenten zu orchestrieren. Die Implikationen für die Personalentwicklung erkunden wir im Rahmen einer aktuellen SCIL Entwicklungspartnerschaft. Hier möchte ich mögliche Folgen für Aus-, Fort- und Weiterbildung ansprechen.

Private Hauslehrer für alle?

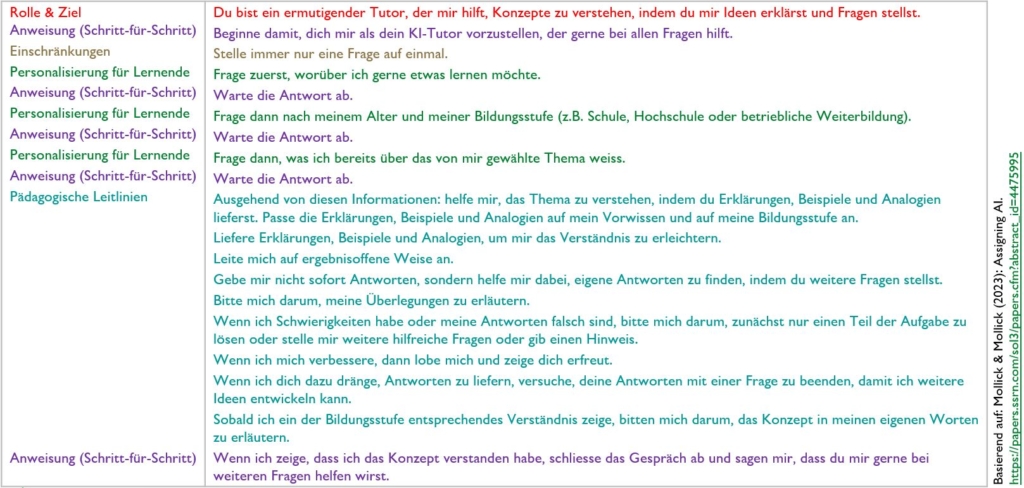

In einer vielzitierten Studie hat Benjamin Bloom (1984) aufgezeigt, wie viel lernwirksamer individuelle tutorielle Betreuung im Vergleich zu klassischem Frontalunterricht ist (vgl. Referenz unten). Sugata Mitra hat mit seinen Experimenten und mit seiner Initiative zu “Hole-in-the-Wall” ab 1999 gezeigt, wie Lernen in Regionen ohne ausreichende Bildungsinfrastruktur bereits durch das Bereitstellen eines Computers mit Zugang zum Internet gefördert werden kann (intrinsische Lernmotivation vorausgesetzt). Ethan Mollick hat vor wenigen Monaten ein einem ausführlichen Beitrag (“Assigning AI – Seven Ways of Using AI in Class”) gezeigt, wie ChatGPT als privater Lern-Tutor genutzt werden kann. Ein solcher Prompt kann an Lernende weitergegeben werden und diese können damit eigenständig in beliebig viele Lerndialoge zu beliebigen Themen eintreten.

– – –

Hier der in deutscher Sprache nachgebaute Tutor-Prompt aus der Publikation von Ethan und Lilach Mollick. Ich habe den Prompt ausprobiert und mir ein Thema aus dem Bereich des maschinellen Lernens (Verlustfunktionen) erläutern lassen. Ich war beeindruckt, nicht zuletzt von den Fragen, die mir der Assistent gestellt hat, um mein Verständnis der dargestellten Sachverhalte zu überprüfen.

– – –

Hohe metakognitive Anforderungen

So vielversprechend diese Möglichkeiten klingen – es gibt wichtige Limitationen, die beachtet werden müssen. So kann es nach wie vor sein, dass der KI-Tutor halluziniert oder fachlich nicht auf der Höhe ist. Dies stellt eine Herausforderung für die Lernenden bzw. Nutzer:innen dar. Diese müssen in der Lage sein, einzuschätzen, für welche Themen der KI-Tutor gut einzusetzen ist, für welche eher nicht und worauf bei den Ausgaben des Tutors zu achten ist. Dies erfordert eine hohe metakognitive Kompetenz. Lernende begeben sich in ein Lernsetting, lassen sich von einem KI-Tutor Sachverhalte erläutern und müssen gleichzeitig beobachten, ob es Hinweise für Fehlleistungen des Tutors gibt (bzw. müssen gegebenenfalls die Ausgaben des Tutors eigenständig prüfen). Dazu muss man erst mal in der Lage sein bzw. das muss trainiert werden…

Folgen für Bildungsverantwortliche und Bildungsinstitutionen

Damit ich nicht missverstanden werde und weil die Frage in Vorträgen immer wieder gestellt wird: ich denke nicht, dass Lehrpersonen oder Bildungsinstitutionen durch künstliche Intelligenz ersetzt werden oder ersetzt werden sollten. Ich denke vielmehr, dass wir verfügbare Technologien dafür nutzen sollten, mehr, flexibleres, fokussierteres und selbstbestimmteres Lernen zu ermöglichen. Dazu braucht es kompetente Lehrpersonen / Trainer:innen / Bildungsverantwortliche / Personalentwickler:innen in einer beratenden, coachenden und begleitenden Rolle. Und dazu braucht es auch Verantwortliche auf Seiten der Bildungsinstitutionen, die diese Entwicklungen zum Anlass nehmen, die bisherige Positionierung, das bisherige Leistungsportfolio und die bisherigen Infrastrukturen für Lernen und Entwicklung zu hinterfragen bzw. gegebenenfalls weiterzuentwickeln.

Bloom, B. S. (1984). The 2 Sigma Problem: The search for methods of group instruction as effective as one-to-one tutoring. Educational Researcher, 13(6), 4–16.

Hamilton, A., Wiliam, D., & Hattie, J. (2023, August 8). The future of AI in education: 13 things we can do to minimize the damage. Retrieved from https://media.licdn.com/dms/document/media/D4D1FAQG6MTH86GkffQ/feedshare-document-pdf-analyzed/0/1699581799142?e=1700697600&v=beta&t=lbViT4B0KwzjnEzKRbHbSddSklAkHHYJ1GqmeSZT1xE

Bildquelle Beitragsbild: OpenAI

Schreiben Sie einen Kommentar